شبکههای عصبی بازگشتی (RNN)

الگوریتم شبکههای عصبی بازگشتی (RNN) برای پردازش دادههای دنبالهای مانند سریهای زمانی طراحی شده است. این مدلها با استفاده از اتصالات بازگشتی میتوانند اطلاعات تاریخی را در نظر گرفته و پیشبینیهای دقیقتری انجام دهند. مقاله به بررسی انواع RNN مانند LSTM و GRU و کاربردهای آنها در پیشبینی قیمت ارز دیجیتال و سایر زمینهها پرداخته است.

الگوریتم شبکه های عصبی بازگشتی (RNN) بهعنوان یکی از پیشرفتهترین ساختارهای یادگیری عمیق شناخته میشوند که بهطور خاص برای پردازش دادههای دنبالهای طراحی شدهاند. بر خلاف شبکههای عصبی سنتی که تنها به ورودیهای مستقل پرداخته و ارتباطات بین آنها را نادیده میگیرند، RNNها قادرند تا با حفظ اطلاعات از حالتهای قبلی، الگوها و ویژگیهای زمانی را در دادهها شناسایی کنند. این ویژگیها به RNNها اجازه میدهد تا در زمینههایی مانند پردازش زبان طبیعی، شناسایی گفتار و پیشبینی سریهای زمانی عملکرد بسیار خوبی داشته باشند.

RNNها با ایجاد اتصالات بازگشتی، اطلاعات را در طول زمان حفظ کرده و در هر مرحله زمانی به ورودی جدید واکنش نشان میدهند. با این حال، بهدلیل مشکلاتی مانند محو شدن و انفجار گرادیان، کارایی آنها در یادگیری از دنبالههای طولانی محدود است. به همین دلیل، انواع پیشرفتهتری از RNN، مانند LSTM و GRU، برای بهبود این معضلات توسعه یافتهاند.

در این مقاله، به بررسی اصول کارکرد، ساختار و کاربردهای مختلف شبکههای عصبی بازگشتی خواهیم پرداخت و چالشها و فرصتهای موجود در این حوزه را تحلیل خواهیم کرد. هدف ما این است که نشان دهیم چگونه RNNها میتوانند به عنوان ابزاری قدرتمند در حل مسائل پیچیدهی مرتبط با دادههای دنبالهای مورد استفاده قرار گیرند.

پیشنهاد مطالعه: واحدهای بازگشتی دروازهای GRU

Table of contents [Show]

- 1 معرفی الگوریتم شبکه های عصبی بازگشتی

- 2 اهمیت الگوریتم شبکه های عصبی بازگشتی

- 3 ساختار RNN

- 4 مشکل گم شدن گرادیان (Vanishing Gradient)

- 5 انواع شبکههای عصبی بازگشتی

- 6 نحوه کارکرد RNN در پردازش دادههای دنبالهای

- 7 مزایای شبکههای عصبی بازگشتی

- 8 معایب شبکههای عصبی بازگشتی

- 9 کاربرد شبکههای عصبی بازگشتی

معرفی الگوریتم شبکه های عصبی بازگشتی

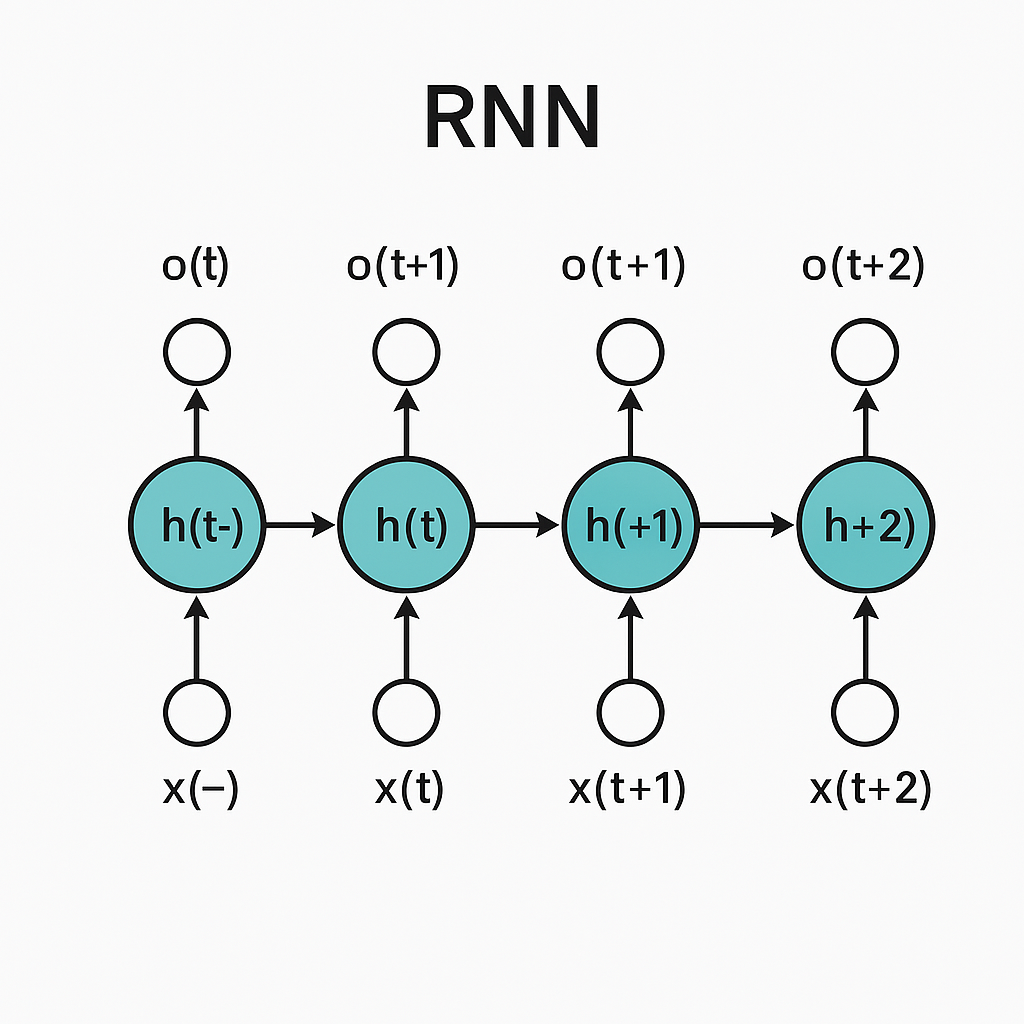

RNN ها به شبکههای عصبی گفته میشوند که قادرند دادههای ترتیبی یا دنبالهای (مثل متن یا سری زمانی) را پردازش کنند. در این مدلها، اطلاعات از یک گام زمانی به گام بعدی منتقل میشود، به این معنا که مدل به یادآوری ورودیهای قبلی خود نیاز دارد تا ورودیهای بعدی را بهتر درک کند.

اهمیت الگوریتم شبکه های عصبی بازگشتی

معمولیترین شبکههای عصبی (مثل شبکههای عصبی پیشخور) برای دادههایی که دارای وابستگی زمانی یا دنبالهای هستند (مثل تحلیل متن یا پیشبینی قیمت ارز دیجیتال) مناسب نیستند. در چنین مسائلی نیاز است که مدل بتواند اطلاعات قبلی را به یاد بیاورد و در تصمیمگیریهای بعدی خود از آن استفاده کند. اینجاست که RNN وارد عمل میشود.

ساختار RNN

ساختار کلی یک RNN ساده به این صورت است:

- هر ورودی به شبکه عصبی به یک واحد (cell) وارد میشود.

- این واحدها به صورت ترتیبی و با استفاده از یک حلقه بازگشتی (feedback loop) به یکدیگر متصل هستند.

- خروجی هر واحد هم به گام زمانی بعدی فرستاده میشود تا در پردازشهای بعدی استفاده شود.

- به عبارت دیگر، RNN از هر ورودی، وضعیت قبلی خود را یاد میگیرد و از این وضعیت برای پیشبینیهای بعدی استفاده میکند.

فرمول ریاضی RNN ساده

فرمولی که برای یک واحد از RNN به کار میرود به این شکل است: ht=f(Whxt+Whhht−1+b)h_t = f(W_h x_t + W_hh h_{t-1} + b)ht=f(Whxt+Whhht−1+b) که در آن:

- hth_tht : وضعیت یا مخفیکاری در گام زمانی ttt است.

- xtx_txt : ورودی در گام زمانی ttt .

- WhW_hWh : وزنهای اتصال ورودی به وضعیت.

- WhhW_hhWhh : وزنهای اتصال وضعیت قبلی به وضعیت جدید.

- ht−1h_{t-1}ht−1 : وضعیت یا مخفیکاری گام زمانی قبل.

- fff : یک تابع فعالسازی مانند tanh یا ReLU.

- bbb : بایاس.

مشکل گم شدن گرادیان (Vanishing Gradient)

در RNNهای استاندارد، وقتی که شبکه خیلی عمیق و طولانی میشود (یعنی تعداد گامهای زمانی زیاد میشود)، مدل با مشکل گم شدن گرادیان (Vanishing Gradient) مواجه میشود. این مشکل زمانی رخ میدهد که گرادیانها در هنگام بهروزرسانی وزنها، خیلی کوچک میشوند و مدل قادر به یادگیری اطلاعات از گامهای زمانی دور نمیشود.

انواع شبکههای عصبی بازگشتی

برای حل مشکلاتی که در RNNهای ساده وجود دارد، انواع مختلفی از RNNها به وجود آمدهاند که بهبودهایی در یادگیری و پردازش دادههای دنبالهای دارند. از مهمترین انواع آنها میتوان به موارد زیر اشاره کرد:

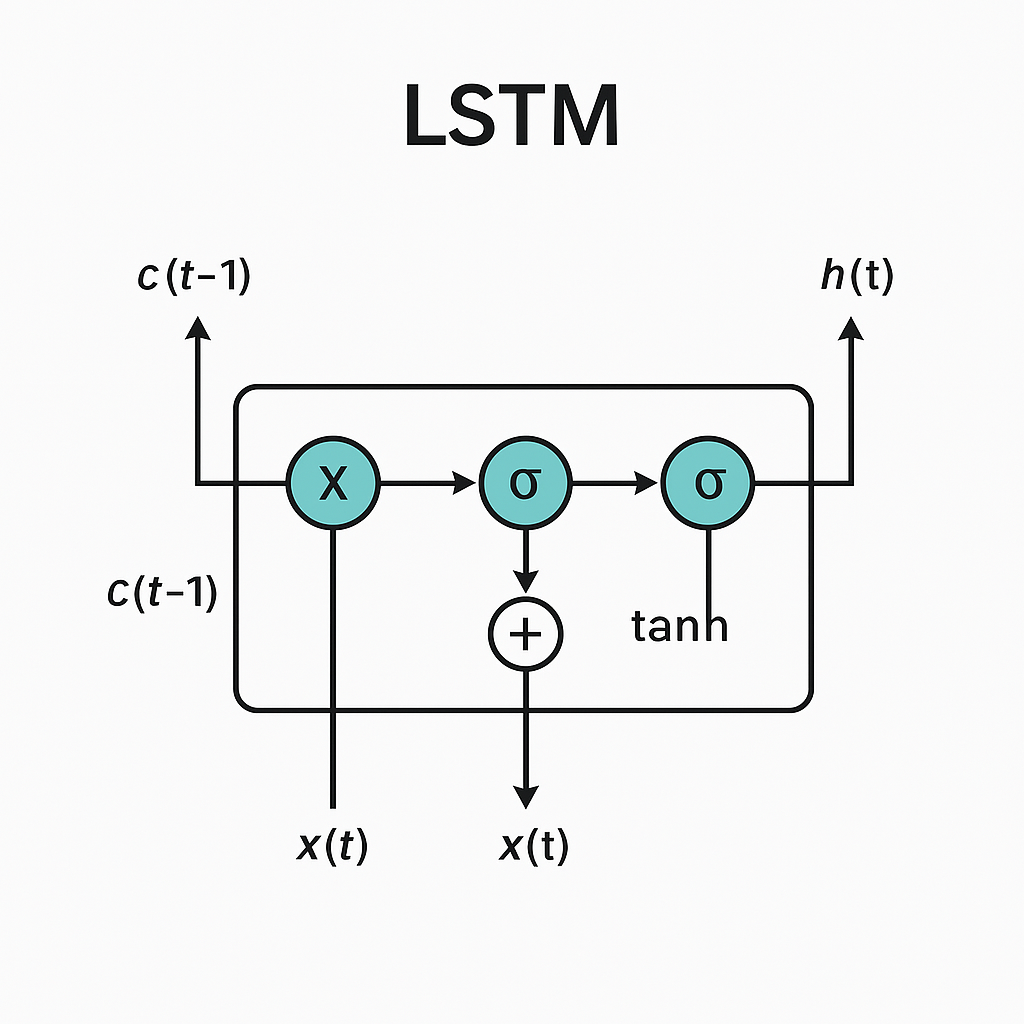

LSTM (Long Short-Term Memory)

- LSTM یکی از معروفترین انواع RNN است که به منظور حل مشکل گم شدن گرادیان ایجاد شده است.

- در LSTM، به جای داشتن یک وضعیت یا مخفیکاری ساده hth_tht ، سه نوع گیت داریم:

- گیت ورودی: تصمیم میگیرد چه اطلاعات جدید به وضعیت حافظه وارد شود.

- گیت فراموشی: تصمیم میگیرد که چه اطلاعاتی از حافظه حذف شود.

- گیت خروجی: تصمیم میگیرد که چه اطلاعاتی از حافظه به خروجی برود.

پیشنهاد مطالعه: آشنایی با الگوریتم حافظه طولانی کوتاه مدت

این ساختار به LSTM کمک میکند که بتواند اطلاعات بلندمدت را در طول زمان حفظ کند و در عین حال از فراموشی اطلاعات مهم جلوگیری کند.

GRU (Gated Recurrent Unit)

- GRU به نوعی نسخه سادهشده از LSTM است که از دو گیت (گیت فراموشی و گیت ورودی) به جای سه گیت استفاده میکند.

- GRU به دلیل سادگی بیشتر، معمولاً در مسائل پیچیدهتری مانند پردازش زبان طبیعی استفاده میشود.

Bidirectional RNN

- در Bidirectional RNN، دادهها به صورت دوطرفه پردازش میشوند. این یعنی اطلاعات از گامهای زمانی گذشته و آینده به طور همزمان مورد توجه قرار میگیرند.

- این مدل برای کارهایی مثل ترجمه ماشینی که نیاز به اطلاعات از هر دو طرف دنباله دارند، مفید است.

Deep RNN

- یک Deep RNN شامل چندین لایه از RNN است که در هر لایه اطلاعات ورودی از لایه قبلی گرفته میشود.

- این ساختار به مدل این امکان را میدهد که ویژگیهای پیچیدهتری از دادهها را یاد بگیرد.

نحوه کارکرد RNN در پردازش دادههای دنبالهای

RNNها برای دادههایی که دنبالهای هستند، بسیار کاربردیاند. برای مثال، در پیشبینی قیمت ارز دیجیتال:

- هر روز قیمت ارز دیجیتال یک ورودی به شبکه است.

- RNN باید از این قیمتها در کنار یکدیگر یاد بگیرد که چگونه قیمت روزهای قبل بر قیمت روزهای بعدی تاثیر میگذارد.

- شبکه به کمک اتصالهای بازگشتی خود میتواند این تاثیرات را در طول زمان دنبال کند و پیشبینی دقیقی از قیمت آینده داشته باشد.

مزایای شبکههای عصبی بازگشتی

- توانایی پردازش دادههای دنبالهای: برخلاف شبکههای عصبی معمولی که فقط دادههای مستقل از هم را پردازش میکنند، RNNها میتوانند وابستگیهای زمانی و دنبالهای را به خوبی یاد بگیرند.

- یادگیری اطلاعات بلندمدت: با استفاده از انواع مختلف RNN مثل LSTM و GRU، مدل میتواند از دادههای قبلی که برای پیشبینیهای آینده مهم هستند، استفاده کند.

معایب شبکههای عصبی بازگشتی

- مشکل گم شدن گرادیان: همانطور که قبلاً اشاره شد، یکی از معایب بزرگ RNNهای ساده مشکل گم شدن گرادیان است که باعث میشود مدل نتواند اطلاعات بلندمدت را به خوبی یاد بگیرد.

- کندی در پردازش: به دلیل پردازش سریالی دادهها، RNNها معمولاً سرعت کمتری نسبت به مدلهای دیگر دارند.

کاربرد شبکههای عصبی بازگشتی

- پیشبینی سریهای زمانی: مثل پیشبینی قیمت ارز دیجیتال.

- پردازش زبان طبیعی: ترجمه ماشینی، تحلیل احساسات، و تولید متن.

- تشخیص صدا و گفتار: تشخیص کلمات و جملات در دادههای صوتی.

- تشخیص ویدیو: پردازش و تحلیل ویدیوهای مختلف برای شناسایی رویدادها و فعالیتها.

نتیجهگیری:

شبکههای عصبی بازگشتی (RNN) یک الگوریتم بسیار قدرتمند هستند که بهطور خاص برای پردازش دادههای ترتیبی طراحی شدهاند. انواع مختلفی از RNNها، مانند LSTM و GRU، وجود دارند که به حل مشکلاتی که در مدلهای سادهتر مشاهده میشود، کمک میکنند. این الگوریتمها در بسیاری از کاربردها، از جمله پیشبینی قیمت ارز دیجیتال، پردازش زبان طبیعی و تشخیص صدا، بهطور گستردهای مورد استفاده قرار میگیرند.

مریم گوهرزاد

مدرس و بنیانگذار هلدینگ آرتا رسانه. برنامه نویس و محقق حوزه بلاکچین